EU gegen KI-Software: Droht das Ende der Innovation?

Als eher technisch orientierter Mensch neigt man dazu, um rechtliche Themen einen großen Bogen zu machen. Man stöhnt über die Cookie-Notice und die Datenschutzerklärung für die eigene Webseite, liest nur widerwillig Lizenzbedingungen und klickt – genau wie Otto Normalsurfer – fast überall einfach auf „OK“.

Aber manchmal holt auch den technischen Unternehmer der lange Arm des Gesetzes wieder in die harsche Realität zurück: Die Datenschutz-Grundverordnung war so ein Fall: Eigentlich musste jeder grundlegende Geschäftsprozesse neu entwerfen und zum Teil auch erstmals dokumentieren. So ganz erholt haben wir uns noch nicht von ihr und aufgeholt haben die meisten auch noch nicht.

Die neue EU-Verordnung zur Künstlichen Intelligenz (KI) verspricht eine ähnliche Umwälzung. Aktuell ist der ganze Bereich KI ja geprägt von Mini-Firmen, die fröhlich neue „Produkte“ aus der Taufe heben, von denen die meisten nur ChatGPT neu einkleiden. Gleichzeitig suchen Konzerne nach einer Positionierung zum Thema KI, die intern nicht zu disruptiv ist, während ihre Mitarbeiter schon lange tägliche Tasks an Bots delegieren. Dass in beiden Fällen völlig ungesteuert sensible Firmen- oder Nutzerinformation und möglicherweise auch DS-GVO geschützte Daten auf OpenAIs Servern landen und bleiben, zeigt schon, wie notwendig ein besseres Bewusstsein für diese Risiken und auch eine gesetzliche Regulierung ist.

Der Entwurf der neuen EU-KI-Verordnung ist sehr risikogetrieben: Einsatz von KI in Softwareprodukten und Prozessen ist umso strikter reguliert, je höher das Risikos ist, dass diese Produkte Grundrechte oder Unversertheit ihrer Nutzer gefährden. Das heißt, ein System für autonomes Fahren ist deutlich strengeren Auflagen unterworfen als ein ChatBot auf einer eCommerce-Seite. Soweit, so gut, aber welche System fallen eigentlich unter diese Verordnung?

Was ist eigentlich Künstliche Intelligenz?

Schon seit einem halben Jahrhundert diskutieren echte und selbsternannte Experten darüber, welche Art von Software eigentlich überhaupt „Künstliche Intelligenz“ genannt werden sollte. Im Verlauf der Zeit wurden viele Verfahren erst als KI gesehen und später dann als „Alltagstool“ oder „Spielerei“ eingestuft. Die einzige kontinuierlich gültige Definition war eigentlich: „Software, die auf eine Weise intelligent wirkt, die den Nutzer überrascht. Software, die intelligenter ist als ein Nutzer von einem Computer erwartet.“ Es besteht kein Zweifel, dass ChatGPT aktuell unter diese Definition fällt. Es besteht aber auch kein Zweifel, dass sich im Laufe der Zeit ändert, was ein Nutzer an Intelligenz von einem Softwareprodukt erwartet.

Die EU wählt also eine „etwas“ trockenere, dafür aber zeitlose Definition:

„Software, die mit einer oder mehreren der in Anhang I aufgeführten Techniken und Konzepte entwickelt worden ist und im Hinblick auf eine Reihe von Zielen, die vom Menschen festgelegt werden, Ergebnisse wie Inhalte, Vorhersagen, Empfehlungen oder Entscheidungen hervorbringen kann, die das Umfeld beeinflussen, mit dem sie interagieren“.

Anhang I wiederum listet folgenden Techniken und Konzepte:

- „Konzepte des maschinellen Lernens, mit beaufsichtigtem, unbeaufsichtigtem und bestärkendem Lernen unter Verwendung einer breiten Palette von Methoden, einschließlich des tiefen Lernens (Deep Learning)

- Logik- und wissensgestützte Konzepte, einschließlich Wissensrepräsentation, induktiver (logischer) Programmierung, Wissensgrundlagen, Inferenz- und Deduktionsmaschinen (symbolischer) Schlussfolgerungs- und Expertensysteme

- Statistische Ansätze, Bayessche Schätz-, Such- und Optimierungsmethoden“

Das heißt, eine Produktsuchmaschine ist keine KI, solange sie kein probabilistisches Ranking verwendet. Aber sobald zum Beispiel eine Produkttaxonomie zum Einsatz kommt, um Synonyme „mitzusuchen“ , handelt es sich eigentlich streng genommen um ein System, das Inhalte und Empfehlungen hervorbringt, indem es eine Wissensrepräsentation verwendet. Diese Definition ist also überraschend weit gefasst und aus meiner Sicht dürften die meisten moderneren Softwaresysteme zumindest in Teilen hierunter fallen.

Software mit Risiko

Zusammen mit der Tatsache, dass die Verordnung für alle Unternehmen und Organisationen relevant ist, die KI-Systeme in der EU entwickeln oder anbieten, heißt das: Fast jedes Softwareunternehmen sollte jetzt prüfen, ob es betroffen und auf welcher Ebene der Risikohierarchie es anzusiedeln ist. Egal, wie der genaue Text der Verordnung am Ende lauten wird, je höher die Risikobewertung, desto strenger werden auch die Auflagen sein, die zu erfüllen sind.

Unannehmbares Risiko: Gericht hat die Kontrolle

Auf der obersten Risiko-Stufe befinden sich Systeme, deren Einsatz verboten bzw. nur in Ausnahmefällen mit richterlicher Genehmigung erlaubt ist. Das sind insbesondere solche, die Grundrechte wie z.B. das Recht auf Privatsphäre beeinträchtigen. Dazu gehört „Social Scoring“ – also Menschen automatisiert zu bewerten oder zu belohnen – genauso wie intelligente Überwachungskameras im öffentlichen Raum. Eine Ausnahmegenehmigung könnte hier bei besonderen Formen von akuter Bedrohung, wie zum Beispiel durch einen Terroranschlag, erteilt werden.

Hohes Risiko: Experte hat die Kontrolle

Systeme mit hohem Risiko sind nicht grundsätzlich verboten, müssen aber sehr weitreichende Auflagen erfüllen. Hierzu gehören Anforderungen an die Dokumentation und Transparenz des KISystems, an die Qualität der Trainingsdaten (Stichwort: Bias und Diskriminierung) und an die proaktive Risikobewertung und -minderung. Wegen des hohen Risikos müssen solche System besonders sicher, transparent und auch überwacht sein. Hier sitzt also meistens ein Mensch am Not-Aus-Schalter. Dazu gehören alle System, die sich nachteilig of Sicherheit oder Grundrechte auswirken können, z.B. bei einer Fehlfunktion. KI-basierte Ampeln und Chirurgie-Roboter fallen hierunter genauso wie automatisierte HR-Systeme für die Analyse von Bewerbungen.

Geringes Risiko: Nutzer hat die Kontrolle

Während man sich einem Chirurgie-Roboter nicht entziehen kann, wenn eine entsprechende Behandlung einmal begonnen hat, kann man die Kommunikation mit einem Heizungsberatungsbot jederzeit ohne große Konsequenzen beenden. Solchen Systemen wird deshalb ein nur geringes Risiko zugeschrieben. Es besteht zwar die Gefahr, dass ich in meinen Entscheidungen beeinflusst, also manipuliert werde, aber die Auswirkungen dieser Beeinflussung sind nicht bedrohlich für meine Unversehrtheit oder meine Grundrechte.

Hier ist lediglich eine gewisse Transparenz vorgeschrieben, d.h. einem Nutzer muss jederzeit klar sein, ob er mit einer Maschine oder mit einem Menschen interagiert. So kann er sich im Zweifelsfall entscheiden, die Diskussion mit dem Bot abzubrechen und auf einen menschlichen Berater zurückzugreifen.

Minimales Risiko: Anbieter hat die Kontrolle

Für Systeme mit minimalem Risiko für Bürgerrechte oder Sicherheit entstehen keine zusätzlichen rechtlichen Verpflichtungen, es besteht also nicht mal eine direkte Kennzeichnungspflicht. Zugegebenermaßen wäre es auch eigenartig, wenn jeder NPC (“non-player character”) in einem Videospiel ein Schild hochhalten müsste: „Ich bin eine KI“. Ähnlich gelagert sind z.B. auch Spamfilter. Ich denke, auch das wissensbasierte Produktsuchsystem vom Anfang würde in dieser Klasse landen und von daher weiter unbehelligt seinen Dienst tun können. Natürlich kann man sich aus Marketing- oder anderen Gründen auch mit solchen Systemen den Regelungen für vertrauenswürdige KI freiwillig unterwerfen.

Und was ist mit ChatGPT?

Ist nun das allseits beliebte ChatGPT ein System mit hohem Risiko oder gar völlig unkritisch? Diese Frage hat auch im Gesetzgebungsverfahren zu einigen Diskussionen geführt. Schließlich kann man „Foundation Models“ und deren Ableitungen für ein immens breites Spektrum von Anwendungen einsetzen. ChatGPT kann definitiv Menschen manipulieren, aber diese Fähigkeit spielt keine Rolle, wenn ich es nur dafür einsetze, den Ton meiner wütenden Emails zu entschärfen. Die Einstufung für „General Purpose AI“ ergibt sich also aus dem Zweck des Gesamtsystems, für das sie eingesetzt werden. Für ChatGPT lassen sich Anwendungen in jeder Risikostufe vorstellen. Wird es im Rahmen einer Hochrisiko-Anwendung eingesetzt, müsste es auch die entsprechenden Auflagen erfüllen. Aus meiner Sicht wäre das in seiner aktuellen Form unmöglich.

Generative Foundation-Modelle wie GPT und Llama, d.h. Modelle, die auf einer breiten Datenbasis in großem Unfang trainiert wurden und für eine große Bandbreite an Aufgaben verwendet bzw., angepasst werden können, sollen laut EU-Parlament aber noch zusätzliche Transparenzanforderungen erfüllen:

- Offenlegung, dass der Inhalt durch KI generiert wurde – das sollte kein Problem sein.

- Programmatische Unterbindung der Erzeugung von illegalen Inhalten – das dürfte schwierige umfassend zu lösen sein.

- Veröffentlichung von Zusammenfassungen urheberrechtlich geschützter Daten, die für das Training verwendet wurden – das dürfte spannend werden.

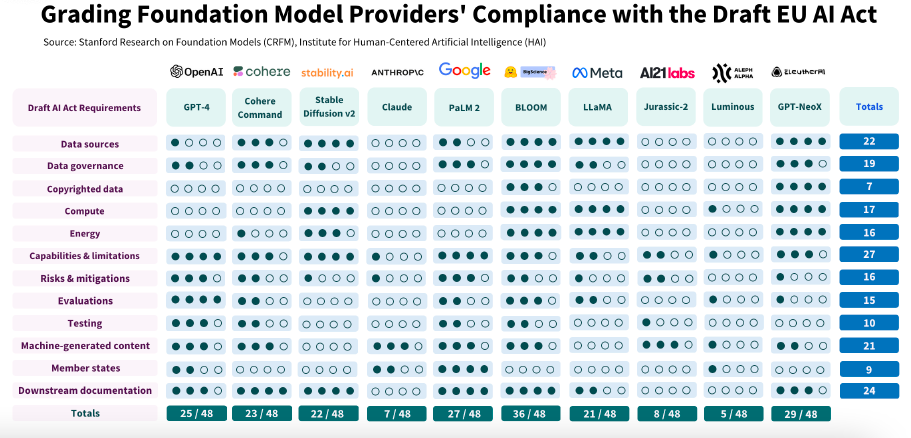

Wendet man diese Regelungen auf aktuelle Modelle an, ist die Bilanz eher dürftig:

Ausblick

Noch ist die Verordnung nicht fertig. Im sogenannten „Trilog“ zwischen Kommission, Parlament und Rat werden gerade die Details ausgearbeitet. Es kann sich also noch einiges ändern. Die Stoßrichtung wird aber wohl die gleiche bleiben und voraussichtlich ab 2026 für alle Anbieter von KI-unterstützter Software verbindlich werden (außer sie wenden sich nicht an EU-Bürger).

Jetzt wäre also ein guter Zeitpunkt, die Produktidee zum KI-gestützen Monitoring aller Call-Center-Mitarbeiter nochmal zu überdenken, um nicht in zwei Jahren die Existensgrundlage zu verlieren. Wer andererseits nicht unmittelbar betroffen ist, zum Beispiel, weil das eigene Produkt in die Kategorie „minimales Risiko“ fällt, kann sich zumindest freuen, das festgestellt zu haben, ohne die 394 Seiten des Gesetzesentwurfs selbst lesen zu müssen. Natürlich handelt es sich bei diesem Beitrag aber um keine Rechtsberatung oder auch nur eine in irgendeiner Weise umfassende Zusammenfassung des Gesetzestextes.